英伟达GTC 2024大会发布GB200芯片及配套架构,通过提升GPU互联带宽、采用高性能光模块和交换机,并部署液冷技术,推动AI计算效能与数据中心能效升级。–通信百科公众号注!

在英伟达 GTC 2024 大会上,黄仁勋发表“见证 AI 的变革时刻”演讲,并推出了GB200芯片及相关架构,通过大幅提升GPU间的互联带宽并采用1.6T光模块。同时发布全球首批端到端800G吞吐量的InfiniBand和以太网交换机,以及采用液冷技术的服务器解决方案,全方位推动AI计算性能革新和数据中心能效提升。

1 高速光模块

在GTC 大会上,英伟达揭晓了新一代 GB200 芯片,业界正密切关注这款芯片如何重塑光模块市场需求格局。

在去年五月末的 COMPUTEX 展会上,英伟达首度公开其 GH200 芯片。经估算,在由256颗GH200构建的集群配置中,所需的800G光模块数量高达2304个,平均每颗芯片配备的光模块比例达到了空前的1:9。

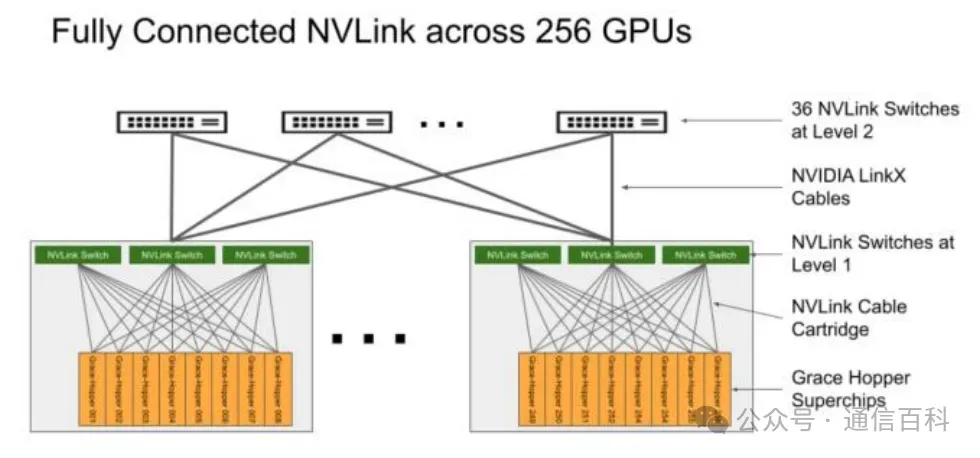

本次发布会上崭露头角的GB200同样秉持了这一设计理念,依据黄仁勋在演讲中的披露,单个GPU之间的双向通信带宽已经由先前的900GB/s跃升至1800GB/s。而在集群配置上,一个标准机柜能装载上限为72颗BlackwellGPU,借助新一代NVLink5交换技术,可以实现多达576颗GPU的互联;并且通过InfiniBand或以太网交换机,集群规模还可进一步扩容至上万个GPU节点。

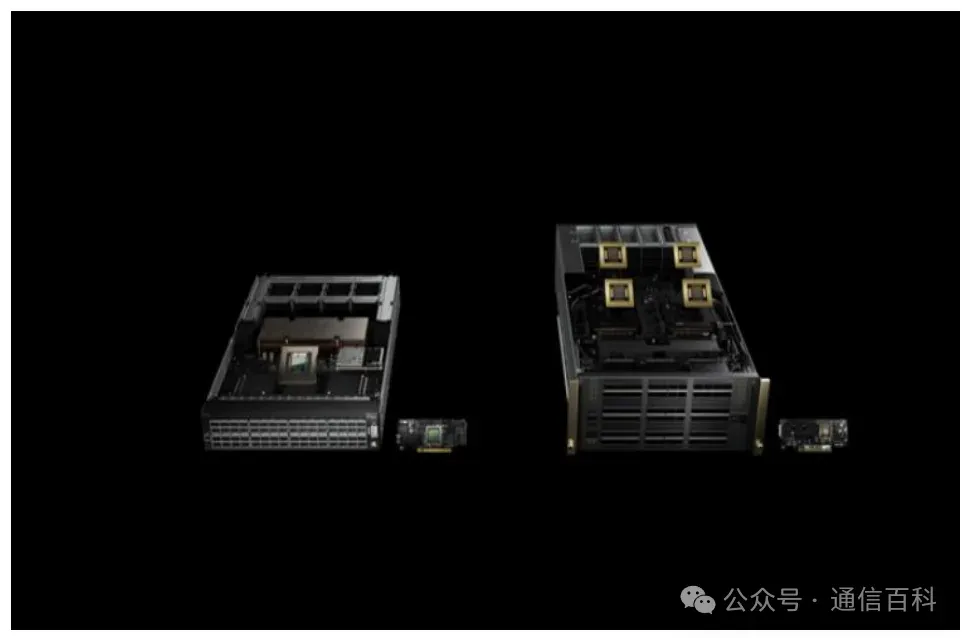

该方案在单台机架中配置了 36 颗 GRACE CPU 和 72 颗 Blackwell GPU,通过铜缆的方案将该 72 颗 Blackwell GPU 进行互联,这一点与 GH200 方案类似,即:第一层网络无需光模块互联。

正如黄仁勋主题演讲所揭示,在GB200的单机柜配置中,得益于全新一代NVLink Switch芯片的支持,GB200能够组建一个由576颗Blackwell GPU构成的计算集群,显著超越了前代GH200所支持的最大256颗GPU集群规模。

就互联带宽而言,集群内的每一颗Blackwell GPU都能实现双向1800GB/s的高速传输,相较于GH200,带宽性能整整翻了一番,这也意味着对应的光模块需承载的带宽加倍,从而催生了对1.6T光模块的需求。

下面我们参照上述逻辑进行估算:

- 在芯片接入层级:单颗GB200芯片具备的双向外部接口带宽为1800GB/s,单向即为900GB/s,因此,所有576颗芯片贡献的接入带宽总量为576乘以900GB/s,合计为518.4TB/s。

- 在芯片层级与L1层级间:通过铜缆直接相连,故在此环节并无光模块需求。

- 在L1层级与L2层级的互联过程中:由于576颗芯片产生的总流量为518.4TB/s,考虑到单个1.6T光模块拥有200GB/s的单向传输能力,那么为了完成数据传输,理论上需要配置518.4TB/s除以200GB/s,即共计2592个光模块,这就意味着L1层的上行线路与L2层的下行线路各自需要2592个光模块,总共需要配备5184个光模块。

据此推算得出,在GB200芯片与1.6T光模块之间,它们的理想使用比例同样是576:5184=1:9,即单个芯片数与光模块的比例为1:9。

2 以太网交换机

英伟达隆重推出了Quantum-X800 InfiniBand系列与Spectrum-X800以太网交换机产品,成为全球率先实现全程800GB/s数据传输速率的网络解决方案,携手英伟达的配套软件套件,能够有力地促进各种类型数据中心内人工智能任务、云端运算、大数据处理以及高性能计算应用的执行效率,此创新同样适用于基于Blackwell架构新近构建的数据中心环境。

英伟达 Quantum-X800 和 Spectrum-X800 交换机

两者的早期应用客户有微软Azure、甲骨文云基础设施和 CoreWeave。其中 Quantum-X800 相比上一代,使用 SHARPv4下的带宽容量提高 5 倍、网络计算能力增加 9 倍至 14.4TFlops。Spectrum-X800 优化网络性能,转为多租户环境设计,可确保每个租户的 AI 工作负载的性能隔离,以保持最佳且一致的性能水平,从而提高客户满意度和服务质量。

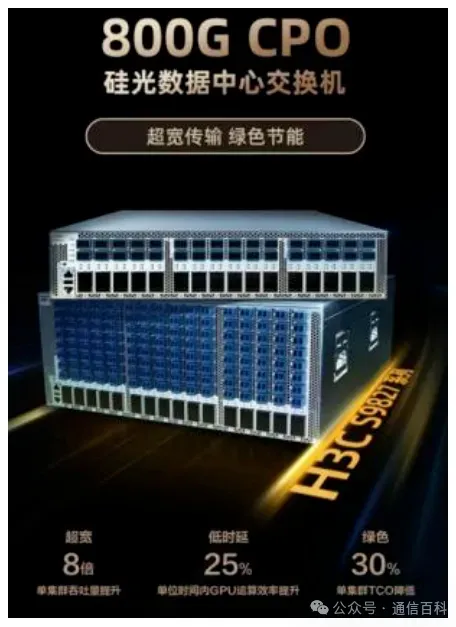

在国内,新华三与华为两大企业紧随交换机技术升级的步伐,相继推出了自家的800G数据中心交换机产品。如新华三在NAVIGATE领航者峰会上全球首度推出了旗下51.2Tbps速率的800G CPO硅光数据中心交换机系列产品——H3C S9827系列。

图:新华三全球首发 800G CPO 硅光数据中心交换机

这款产品内置的单芯片传输速率高达51.2T级别,支持64个800G的端口。在保证高吞吐性能的同时,借由CPO硅光技术的优势,进一步将单端口传输延迟降低了20%,这一改进意味着在同样的时间周期内,AIGC集群内部GPU之间的数据交换能力可以得到25%的增长,显著提升了GPU的整体计算效能。

一样,华为在 2023 年 6 月第 31 届中国国际信息通信展中发布首款 800GE 数据中心核心交换机——CloudEngine 16800-X 系列:

图:华为首发 CloudEngine 16800-X 800GE 数据中心交换机

华为声称其CloudEngine 16800-X支持 288 个 800GE 端口,具备3.5 微秒跨板转发时延,整体TCO可降低 36%。

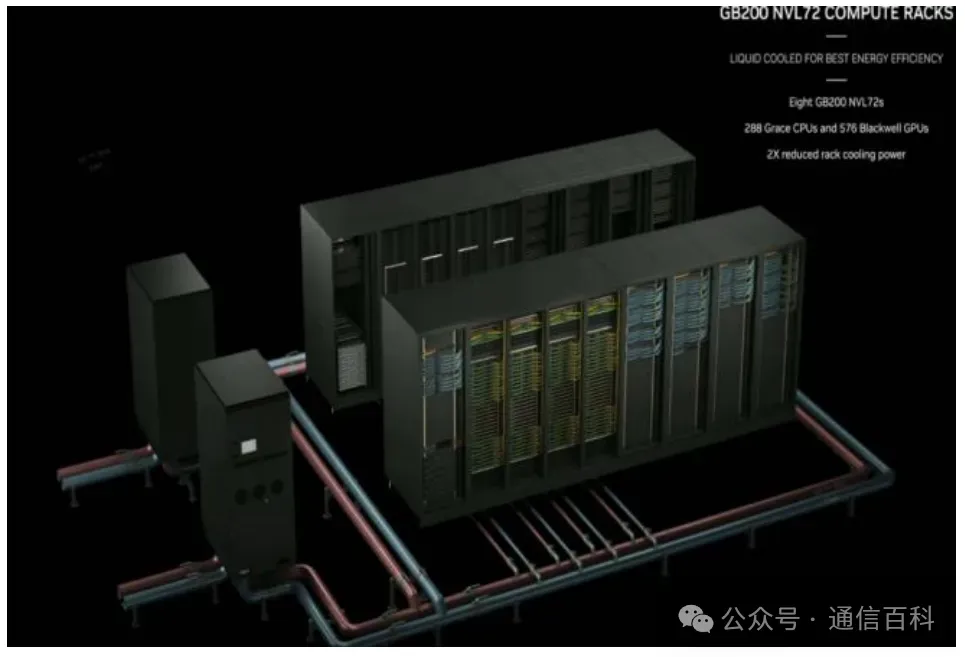

3 液冷技术

在英伟达 GB200 的方案中,其机架具有 2 英里长的 NVLink 布线,共 5000 根电缆,估算其功耗将达 20KW及以上。因此,服务器亟需更高效的散热方式。为了让这些计算快速运行,英伟达将采用液冷的设计方案,冷却液输入/输出水温分别为 25℃/45℃。

除了英伟达,AI 服务器厂商超微电脑预计将在24Q2内扩产液冷机架。

GB200 NVL72 液冷机架示意图

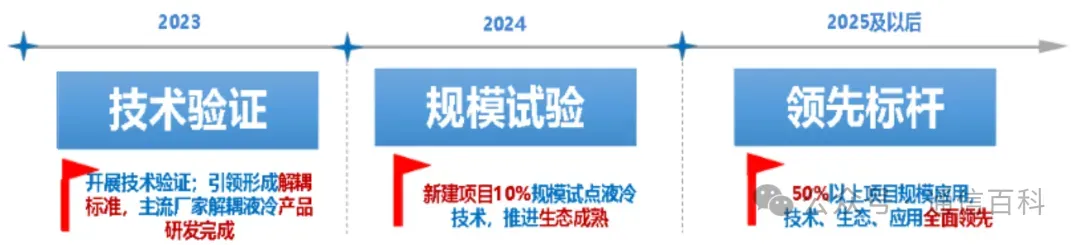

同时,国内产业链也在协同推进液冷技术的发展。三大运营商在去年 6 月发布了《电信运营商液冷技术白皮书》,并提出 25 年及以后液冷在 50%以上项目规模应用的愿景。

电信运营商液冷技术规划