英伟达在其数据中心架构设计上采取了一项颠覆性措施——摒弃部分光模块,转而采用铜缆进行内部互联,这到底是怎么回事?看到网上有人说搞了几十的光进铜退,现在要反着来吗?

那么光模块数量的需求会减少吗?

根据其描述,基于最新一代 NVLink Switch 芯片,GB200 可实现576颗 Blackwell GPU 组成计算集群,超越上一代 GH200 支持的 256 颗集群规模。在GB200方案中,其单台机架中配置了36颗GRACE CPU和72颗Blackwell GPU,通过铜缆的方案将该72颗 Blackwell GPU 进行互联。

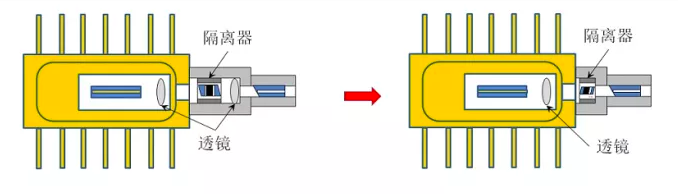

GB200 单机柜方案中采用铜缆进行互联

针对网上狼来了的看法,不禁用两个但是但是,上一代GH200机柜内部不也是用的铜缆而非光模块么,所以GB200单机柜内部采用NVLink5.0铜缆电连接并不稀奇。

综合英伟达的方案,我们分析:小于72个GPU以内的小型集群,英伟达可以全部采用铜缆进行内部互联,无需使用光模块。但是当GPU数量上升至72-576个区间时,也就是跨机柜场景(单机内部还是铜互联),必须大量使用光模块了,无论是800G还是未来的1.6T。

对于超过576个GPU的集群的外部互联,第三层网络采用InfiniBand技术。由于NVLink5.0双向带宽已提升至1800GB,对应单向带宽为900GB,若采用800G光模块传输+2层网络架构,(900GB*8/800Gb)*2=18个,即GB200与800G光模块的配比关系为1:18;如果采用1.6T光模块,配比关系为1:9,与昨天文章中的数据对得上。

从成本角度来看,一个NVL72单机柜需配备5000个200G速率的铜缆,200G速率的单价为45美金,总计22万美金。再把铜缆中间的线材、两端的连接器(每个价格15美元)以及相对成本较低的Cage部件都包含进来,相比光模块的成本还是划算的多。

不过,现阶段采用的是200G铜缆互联,后续可能计划升级至400G,但随着速率的提升,铜缆的传输距离是快速变短的,例如200G铜缆支持7米,400G铜缆为2.5米,800G铜缆则限于1米。因此即使是单机架内的互联,相信最终还是光模块的天下。

分析认为在NVLINK速率提升至7.2TB之前的数年内,铜缆仍是一个可行的替代方案。

在市场上,前一代GH200的销售业绩不尽如人意,市场份额仅为5%,主要客户是AWS。貌似英伟达对新一代GB200产品,预期还是比较乐观的:据说AWS已预订2万张GB200芯片,谷歌、微软等巨头也有意向下单。若定价策略得当,GB200的市场渗透率有可能达到20-40%,甚至更高也不是不可能的。

总结起来说:

短期效应,需求减少,由于GB200方案通过改进的NVSwitch架构和铜缆互联大幅提升了单机柜内部的算力密度,原本需要更大规模集群才能达到的计算需求现在仅需较少数量的机柜就能实现,这意味着在一定规模的集群内部,光模块的使用数量将显著下降,特别是在中小规模的集群搭建中,光模块的需求被大量取代。

长期趋势,尽管在单机柜内部采用铜缆互联,但随着数据中心规模不断扩大,特别是当需求超出单机柜范围时,机柜间的互联仍需依赖光模块,而且随着对更大规模算力集群的需求增加,光模块的使用仍然是必不可少的,只是需求层次发生了变化,即从集群内部转向集群间互联。

技术迭代与需求匹配:随着技术发展和需求变化,当铜缆技术遇到IO瓶颈或其他限制时,光模块很可能会再度成为最优解,就像上面说的当铜缆的传输距离已经不足以支持单机柜内的互联了。

欢迎加入我们的付费社群,持续更新800+天!